Appearance

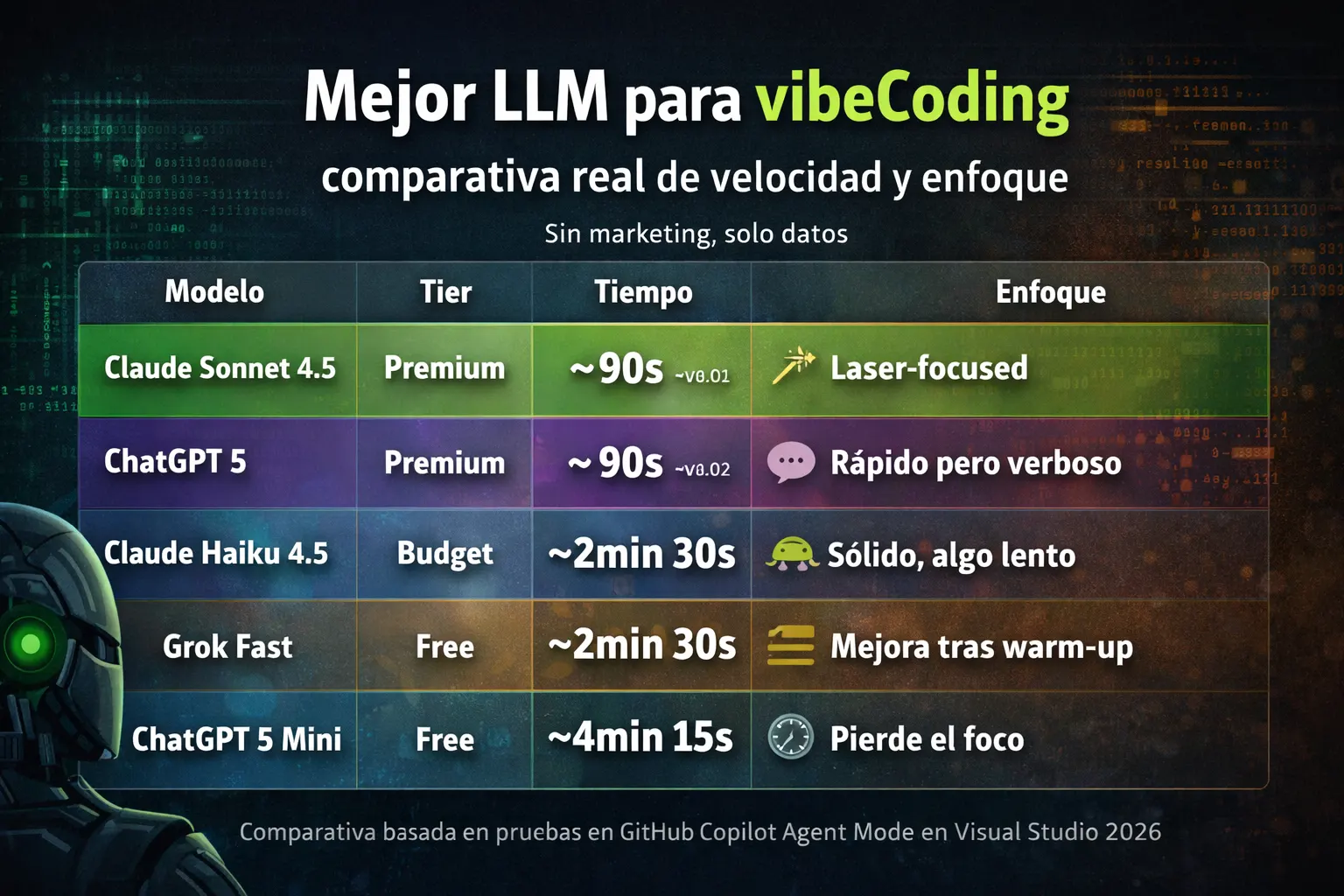

Mejor LLM para vibeCoding: comparativa real de velocidad y enfoque

Sin marketing, solo datos

Esta comparativa está basada en pruebas reales con GitHub Copilot Agent Mode en Visual Studio 2026, no en benchmarks teóricos. La misma tarea, los mismos archivos, todos los modelos.

La prueba

Se probaron 5 modelos de IA en GitHub Copilot Agent Mode con una tarea idéntica para todos: refactorizar la lógica de acceso a datos en 6 clases de repositorio, convirtiendo código síncrono a patrones async/await con optimizaciones de Entity Framework Core.

Una tarea que a un desarrollador humano familiarizado con async le llevaría 15-20 minutos.

Antes (incorrecto):

csharp

public IQueryable<ResultCheckSumSa> GetAll()

{

return _repository.Query<ResultCheckSumSa>();

}

public ResultCheckSumSa GetByItemID(int itemID)

{

return _repository.Query<ResultCheckSumSa>()

.FirstOrDefault(x => x.ItemID == itemID);

}Después (correcto):

csharp

public async Task<IReadOnlyList<ResultCheckSumSa>> GetAll()

{

return await GetAllQuery().ToListAsync()

as IReadOnlyList<ResultCheckSumSa>;

}

public async Task<ResultCheckSumSa> GetByItemID(int itemID)

{

return await GetAllQuery()

.FirstOrDefaultAsync(x => x.ItemID == itemID);

}

private IQueryable<ResultCheckSumSa> GetAllQuery()

{

var itemsQuery = _repository.GetAll<ResultCheckSumSa>()

.AsNoTracking();

return itemsQuery;

}Los cambios: añadir async/await, cambiar Query<T>() por GetAll<T>(), añadir .AsNoTracking(), introducir un método helper y actualizar los tipos de retorno. El mismo patrón en los 6 archivos.

Resultados de velocidad

| Modelo | Tier | Tiempo | Coste | Enfoque |

|---|---|---|---|---|

| Claude Sonnet 4.5 | Premium | ~90s | ~$0.02 | Laser-focused |

| ChatGPT 5 | Premium | ~90s | ~$0.02 | Rápido pero verboso |

| Claude Haiku 4.5 | Budget | ~2min 30s | < $0.01 | Sólido, algo lento |

| Grok Fast | Free | ~2min 30s | $0.00 | Mejora tras warm-up |

| ChatGPT 5 Mini | Free | ~4min 15s | $0.00 | Pierde el foco |

Un humano: 15-20 minutos. El mejor modelo: 90 segundos.

Qué hizo cada modelo

Claude Sonnet 4.5 — El cirujano

Ejecución quirúrgica. Completó exactamente lo pedido, nada más. Sin sugerencias extras, sin tangentes, sin ruido. Aplicó el patrón async/await, los cambios de repositorio y AsNoTracking de forma consistente en los 6 archivos.

Si fuera un desarrollador humano, sería el que lee el ticket, arregla exactamente lo especificado, envía el PR y sigue adelante.

ChatGPT 5 — El colega verboso

Igual de rápido pero más hablador. Quiso comentar el estilo del código, proponer optimizaciones adicionales y discutir enfoques alternativos. El trabajo fue correcto, pero vino con comentarios que nadie pidió.

Útil si quieres aprender. Molesto si solo necesitas el fix.

Claude Haiku 4.5 — La opción equilibrada

Aplicó correctamente todos los patrones de refactoring. Tardó más que los premium (~2.5x) pero a un coste significativamente menor. Tuvo un hang inexplicable de ~30 segundos al finalizar.

Buena elección para trabajo no urgente con presupuesto limitado.

Grok Fast — El que mejora con el calentamiento

Primera ejecución: 5 minutos. Segunda: 2 minutos 30 segundos. Mejora dramática que sugiere optimización de backend o caching.

Competitivo con las opciones budget, pero 3x más lento que los premium.

ChatGPT 5 Mini — El turista

En vez de arreglar los 6 archivos especificados, se puso a explorar otros proyectos de la solución. Añadió ~3 minutos extra de paseo innecesario. Gratuito, pero pagas con tu tiempo.

Gratis no siempre es barato.

Bonus: modelos web (chat)

Por curiosidad, se probó la misma tarea en interfaces web (copiar archivos manualmente al chat):

| Modelo | Tiempo de procesamiento |

|---|---|

| DeepSeek | ~55 segundos |

| Claude Sonnet 4.5 (web) | ~10 minutos |

DeepSeek impresiona en velocidad bruta, pero hay que sumarle el tiempo manual de copiar/pegar 6 archivos. Claude web tardó mucho más que vía API, probablemente por carga del servicio gratuito.

La integración con el IDE (Copilot Agent Mode) marca una diferencia enorme frente al copy-paste manual.

¿Cuándo merece la pena pagar?

| Uso | Recomendación |

|---|---|

| Uso ocasional | Modelos gratuitos van bien |

| Varias veces al día | Premium se paga solo (~$0.02/tarea) |

| Trabajo profesional diario | 2-3 min ahorrados x varias veces = horas/semana |

A $0.02 por tarea, necesitas 50 tareas para gastar $1. Para un desarrollador profesional, el ahorro de tiempo justifica el coste con creces.

Recomendaciones prácticas

| Necesidad | Modelo recomendado |

|---|---|

| Velocidad + foco | Claude Sonnet 4.5 |

| Velocidad + explicaciones | ChatGPT 5 |

| Presupuesto limitado | Claude Haiku 4.5 |

| Aprendizaje | ChatGPT 5 (estilo verboso es educativo) |

| Gratuito | Grok Fast (tras warm-up) |

La conclusión

Claude Sonnet 4.5 emerge como la mejor opción general para vibeCoding con GitHub Copilot Agent Mode: combina velocidad (90s), foco disciplinado y coste razonable ($0.02).

ChatGPT 5 iguala la velocidad pero con más ruido. Los modelos gratuitos funcionan, pero esperando 2-3x más de tiempo y menor disciplina.

La velocidad importa. Pero mantenerse en la tarea sin divagar es la verdadera diferencia. Cuando pides un refactoring específico, no quieres una discusión filosófica sobre enfoques alternativos. Quieres el trabajo hecho, limpio y eficiente.

Basado en las pruebas de CodeLess Developer con GitHub Copilot Agent Mode en Visual Studio 2026.